¿Entrenar o Informar a tu IA? La Decisión Clave entre Fine-Tuning y RAG

Has desplegado un LLM de última generación. En las demos, es brillante. Responde a preguntas complejas, genera código y escribe textos con una fluidez impresionante. Pero al conectarlo a tus procesos de negocio, la realidad se te viene encima: no conoce tus productos, no entiende tu jerga interna y, desde luego, no tiene ni idea de quién fue el cliente estrella del último trimestre. Es un genio amnésico dentro de tu propia empresa.

Este es el abismo que separa a una IA genérica de un verdadero activo empresarial. Y para cruzarlo, nos encontramos con una bifurcación crítica, una decisión que definirá la personalidad y la capacidad de nuestra IA: ¿debemos entrenarla para que adquiera una nueva habilidad (Fine-Tuning) o debemos darle acceso a nuestra biblioteca de conocimiento para que pueda consultar información en tiempo real (RAG)?

Cuidado, porque la respuesta no es trivial y la intuición a menudo nos lleva por el camino equivocado. No se trata de elegir una tecnología "mejor", sino de aplicar el patrón de diseño correcto para el problema correcto. Una mala elección aquí no solo dispara los costes y la complejidad, sino que puede resultar en una solución que, en el mejor de los casos, es decepcionante. En este artículo vamos a desmitificar esta elección, analizando desde la arquitectura del software cuándo y por qué debemos optar por un camino u otro.

Patrón 1: Fine-Tuning para la Especialización del Comportamiento

Un arquitecto no elige el Fine-Tuning para "añadirle datos" a un modelo. Ese es el principal error conceptual. Elegimos Fine-Tuning cuando el objetivo es modificar el comportamiento intrínseco del modelo, para enseñarle una habilidad o un estilo de razonamiento que no se puede describir eficazmente en un prompt. Se trata de reescribir parte de su ADN neuronal.

El objetivo no es inyectar conocimiento, sino especializar la habilidad.

Caso de Uso Concreto: Automatización de Informes de Sostenibilidad (ESG)

Imaginemos una consultora que genera informes de Sostenibilidad, Medio Ambiente y Gobernanza (ESG) para empresas del IBEX 35. Estos informes no son un simple resumen de datos; siguen una estructura narrativa muy específica, utilizan una terminología regulatoria precisa y deben adoptar un tono formal y cauteloso.

- El Problema: Un modelo base, incluso con RAG, puede recuperar los datos correctos (emisiones de CO2, políticas de diversidad), pero fallará estrepitosamente en la generación del texto final. Producirá un texto genérico, probablemente con un estilo americano, y no respetará la sutil estructura y el lenguaje que exigen los reguladores europeos.

La Solución Arquitectónica (Fine-Tuning):

Curación del Dataset: El trabajo más arduo. Se crea un dataset de alta calidad con cientos (o miles) de pares prompt/completion.

- Prompt: Podría ser una estructura de datos JSON con los KPIs del cliente:

{"empresa": "ACME Corp", "emisiones_scope1": 45000, "brecha_salarial": 0.08, "iniciativas_comunidad": ["..."]}. - Completion: El párrafo exacto, redactado por un experto humano, tal y como debería aparecer en el informe final, con el tono y la estructura perfectos.

- Selección del Modelo: No siempre necesitamos el modelo más grande. Para una tarea tan específica, un modelo más pequeño y eficiente como Phi-3-medium, ajustado con precisión, puede superar a un GPT-5 genérico en esta tarea concreta, con menor latencia y a una fracción del coste de inferencia.

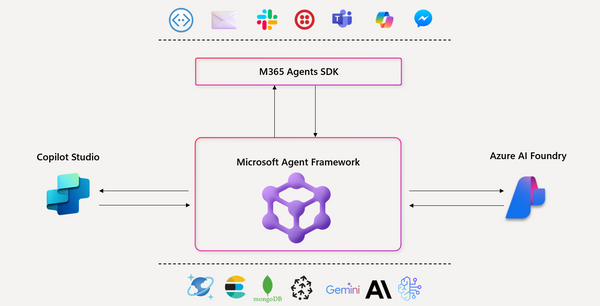

- Proceso en Azure AI Foundry: Se inicia un trabajo de Fine-Tuning, donde el modelo base aprende los patrones de conexión entre los datos de entrada y la prosa de salida deseada. El resultado es un nuevo endpoint de modelo, un activo especializado para la empresa.

Decisión del Arquitecto: Optamos por Fine-Tuning porque el "qué" (los datos) es variable, pero el "cómo" (la estructura, el tono, la jerga) es un patrón de comportamiento estable y complejo que queremos internalizar en el modelo. El coste computacional inicial se justifica porque reduce drásticamente la complejidad del prompt en producción y garantiza una consistencia que RAG por sí solo no puede ofrecer.

Patrón 2: RAG para la Inyección de Conocimiento Contextual y Dinámico

RAG es el patrón de elección cuando el modelo tiene el comportamiento de razonamiento adecuado, pero carece del contexto específico y actualizado para responder. La filosofía aquí es la separación de responsabilidades: el LLM es un motor de razonamiento universal, y la base de conocimiento empresarial es un sistema desacoplado y dinámico.

El objetivo no es cambiar al modelo, sino informarlo en tiempo real.

Caso de Uso Concreto: Asistente de Diagnóstico para Técnicos de Mantenimiento

Pensemos en una empresa que fabrica maquinaria industrial compleja (ej. turbinas eólicas). Sus técnicos de campo se enfrentan a códigos de error y necesitan acceder a manuales de reparación, historiales de mantenimiento y boletines de servicio. Esta base de conocimiento es masiva (cientos de miles de páginas en PDFs), se actualiza constantemente y es absolutamente propietaria.

- El Problema: Ningún modelo pre-entrenado conoce el significado del "código de error 27B en una turbina modelo V-112". Un Fine-Tuning sería inviable y absurdo, ya que la información cambia con cada nuevo boletín de servicio.

La Solución Arquitectónica (RAG):

Pipeline de Ingesta de Conocimiento:

- Origen de Datos: Un Azure Blob Storage donde se depositan los manuales en PDF, esquemas, etc.

- Pre-procesamiento: Un servicio como Azure AI Document Intelligence es crucial aquí. No podemos tratar un PDF técnico como texto plano. Necesitamos extraer tablas, entender diagramas y respetar la estructura del documento antes de procesarlo.

- Chunking (Troceado): Es una decisión de diseño crítica. ¿Troceamos por tamaño fijo? ¿O usamos un troceado semántico que intente mantener párrafos o secciones completas? Para manuales técnicos, el troceado semántico suele dar mejores resultados.

Capa de Indexación y Búsqueda (El Corazón de RAG):

- Vectorización (Embedding): Cada "chunk" se convierte en un vector numérico usando un modelo como

text-embedding-3-small. - Vector Store: Azure AI Search actúa como nuestro almacén vectorial. Implementamos una estrategia de búsqueda híbrida. Esto es clave. La búsqueda vectorial encontrará párrafos semánticamente similares a "el motor se sobrecalienta", pero la búsqueda por palabras clave (keyword search) es indispensable para encontrar referencias exactas a "código de error 27B" o "número de pieza 84A-C3".

Orquestación en Tiempo de Ejecución (Runtime):

- Prompt Flow: Aquí se diseña el flujo lógico.

- El prompt del técnico ("Tengo un error 27B en una V-112, ¿causas probables?") se vectoriza.

- Se realiza la consulta híbrida contra Azure AI Search, recuperando los 5 "chunks" más relevantes.

- Se construye un prompt final que incluye la pregunta original y el contexto recuperado:

"Basándote ESTRICTAMENTE en los siguientes documentos recuperados, responde a la pregunta del usuario. Documentos: [...]. Pregunta: [...]". - Este prompt se envía a un modelo potente en razonamiento como GPT-5, que no inventa nada, sino que sintetiza la respuesta a partir del contexto proporcionado.

Decisión del Arquitecto: RAG es la única opción viable. Desacopla la base de conocimiento (que puede crecer y cambiar a diario) del modelo de lenguaje. La solución es más auditable y fiable, ya que cada respuesta puede ser trazada hasta los documentos fuente recuperados, eliminando casi por completo el riesgo de alucinaciones. El coste es por consulta (OPEX), pero evitamos el coste masivo y la rigidez de un reentrenamiento constante.

El Framework de Decisión del Arquitecto: Conocimiento vs. Comportamiento

Para tomar la decisión correcta, debemos analizar dos ejes principales:

| Eje de Decisión | Favorece Fine-Tuning | Favorece RAG |

| Objetivo Primario | Modificar el comportamiento (estilo, formato, habilidad de razonamiento específico). | Inyectar conocimiento factual, dinámico y propietario. |

| Volatilidad de Datos | El conocimiento subyacente es estable y de larga duración. | Los datos cambian constantemente (diaria, semanalmente). |

| Requisito de Trazabilidad | No es crítico. La respuesta es una habilidad aprendida. | Crítico. Se debe poder citar la fuente exacta de la información. |

| Complejidad de la Tarea | La tarea implica un formato de salida complejo o un estilo no descriptible en un prompt. | La tarea es responder preguntas basadas en un corpus de documentos. |

| Perfil de Coste | CAPEX-like: Inversión inicial alta en curación de datos y entrenamiento. | OPEX-like: Coste por consulta (búsqueda + inferencia con prompts más largos). |

La Arquitectura Híbrida: El Patrón Definitivo

Los casos de uso más avanzados no se conforman con una u otra. Implementan una arquitectura híbrida que combina lo mejor de ambos mundos.

Volvamos al asistente de informes ESG. Nuestra arquitectura ideal sería:

- Un modelo base ajustado (Fine-Tuned): Este modelo ya es un experto en generar la narrativa, la estructura y el tono de un informe ESG. Su habilidad principal es la redacción especializada.

- Un sistema RAG conectado: Este sistema se conecta a las bases de datos internas de la consultora y a las fuentes de datos del cliente.

Cuando se solicita un nuevo informe, el orquestador (Prompt Flow) primero utiliza RAG para recuperar los KPIs y datos numéricos actualizados del cliente. Luego, alimenta estos datos en el modelo ajustado (fine-tuned), que no solo los resume, sino que los teje dentro de la narrativa compleja y el formato predefinido que ha aprendido, produciendo un borrador de informe de altísima calidad.

Esta separación es la clave de una buena arquitectura de software: un componente especializado en el conocimiento (RAG) y otro en la habilidad (Fine-Tuning), trabajando en conjunto.

La elección entre Fine-Tuning y RAG no es una preferencia, es una decisión de diseño basada en un análisis riguroso de los requisitos del negocio. Como arquitectos, nuestro trabajo es entender la naturaleza del problema (si es de conocimiento o de comportamiento) y diseñar una solución robusta, escalable y fiable utilizando las herramientas a nuestra disposición. El verdadero valor no reside en el modelo, sino en la arquitectura que lo rodea.